この記事でわかること

- 実務ですぐ使えるハルシネーション対策プロンプト5選

- 最新モデルでも有効な指示設計の考え方

なぜAIは嘘をつく?ハルシネーションの正体と原因

対策を講じる前に、まず「なぜAIは嘘をついてしまうのか」という根本的な仕組みを理解しておきましょう。仕組みを知ることで、対策の精度が大きく変わります。

ハルシネーションとは

ハルシネーション(幻覚)とは、生成AIが事実に基づかない情報を、あたかも事実であるかのように自信を持って出力してしまう現象のことです。

例えば、実在しない判例を作り上げたり、有名な事件の発生年を間違えたり、計算結果を誤って表示したりするケースが挙げられます。厄介なのは、AIが意図的に嘘をついているわけではないにもかかわらず、非常に自然で流暢な日本語で回答するため、人間が一目で誤りに気づきにくい点です。

主な原因は「確率的な単語予測」

ハルシネーションが起きる最大の理由は、生成AIの仕組みそのものにあります。

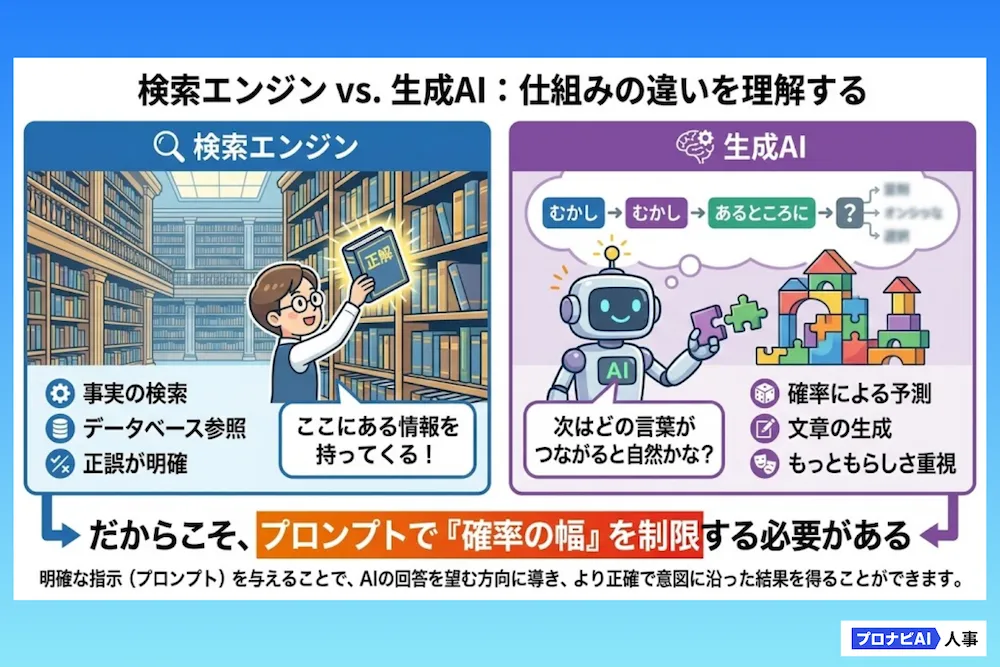

AIは、検索エンジンのように「正しいデータベースから答えを探してくる」わけではありません。過去に学習した膨大なテキストデータを基に、「この単語の次には、確率的にどの単語が来そうか」を予測し、しりとりや連想ゲームのように文章をつなげているにすぎません。

- 検索エンジン: 「事実」を探して提示する(記憶の検索)

- 生成AI: 文脈に合わせて「それっぽい文章」を作る(確率の計算)

つまり、AIにとって重要なのは「事実かどうか」よりも「文章として自然か」という点です。そのため、情報が曖昧な場合でも、文脈を埋めるために「確率的にありそうな嘘」を違和感なく生成してしまいます。

この仕組みを理解すれば、なぜプロンプト(指示)が重要なのかがはっきりしてきます。私たちの指示で「確率の幅」を狭め、事実以外の余計な連想をさせないように制御することこそが、ハルシネーション対策の本質なのです。

【保存版】ハルシネーションを防ぐ対策プロンプト5選

ここからは、コピペしてそのまま使える対策プロンプトを紹介します。

AIの「嘘」を減らすために最も効果的なのは、AIが本来持っている「分からないことも答えようとするサービス精神」を抑制することです。様々な業務で共通して使える必須テクニックを用いたプロンプトを厳選しました。

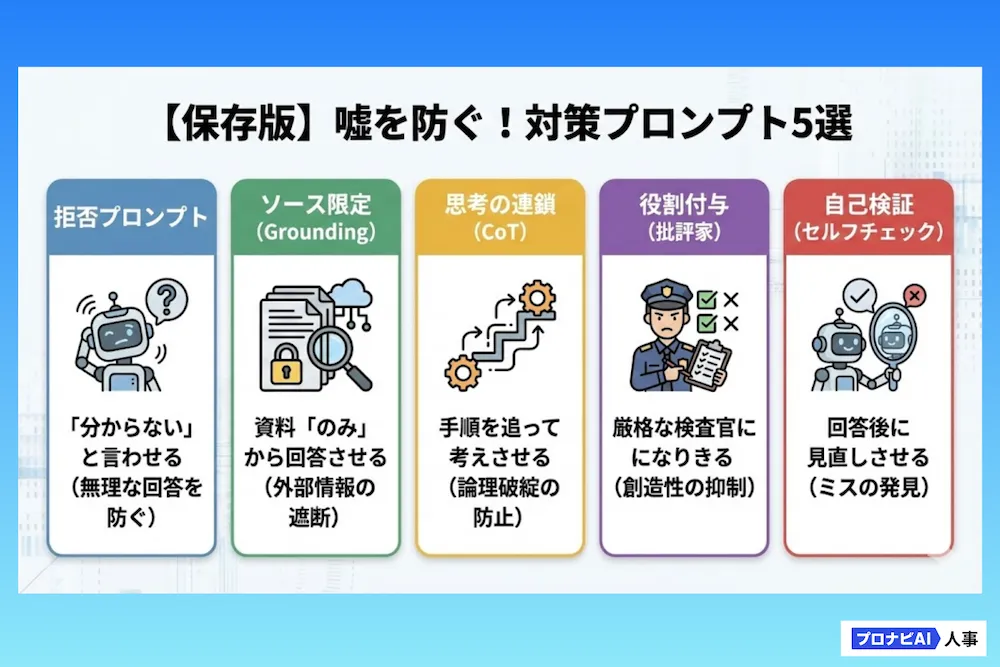

1. 「拒否」プロンプト(分からないと答えて)

AIはデフォルトの状態だと、情報が不足していても、何かしらの回答を無理やりにでも生成しようとします。これを防ぐために、「分からない場合は答えない」というルールを明確に指示しておくことが重要です。

【コピペ用プロンプト】

# 命令書: あなたは誠実なアシスタントです。以下の質問に答えてください。 ただし、確信が持てない場合や情報が不足している場合は、無理に回答を生成せず「分かりません」と答えてください。決して推測で事実を捏造しないでください。 # 質問: (ここに質問を入力)

【なぜ効くのか?】

「答えられない」という選択肢を明示的に与えることで、確率の低い情報を無理につなぎ合わせるリスクを回避します。

【活用シーン】

- 一般的な調べ物

- FAQ作成など全般

2. 「ソース限定」プロンプト(Grounding)

AIの学習済み知識(過去の記憶)を使わせず、「与えた資料」だけを見て回答させる手法です。これを「グラウンディング」と呼び、非常に有効なハルシネーション対策の一つです。

【コピペ用プロンプト】

# 命令書: 以下の[参考テキスト]に記載されている情報「のみ」に基づいて、質問に回答してください。 テキスト内に答えが見つからない場合は、自身の知識を使わず「情報なし」と答えてください。 # 参考テキスト: (ここに記事やマニュアルの文章を貼り付け) # 質問: (ここに質問を入力)

【なぜ効くのか?】

AIの膨大で曖昧な知識に頼らせず、目の前の確実な情報だけを参照させるため、嘘が入り込む余地を物理的に遮断できます。

【活用シーン】

- マニュアルに基づく回答

- 議事録からの情報抽出

3. 「思考の連鎖(CoT)」プロンプト

いきなり結論を出させるのではなく、「考えさせながら」答えを出させる手法です。「Chain of Thought(CoT)」と呼ばれ、論理的な誤りを防ぐ効果があります。

【コピペ用プロンプト】

# 命令書: 以下の課題について回答してください。 いきなり結論を出さず、ステップ・バイ・ステップで手順を追って考えてください。 まず前提条件を整理し、論理的な根拠を明確にした上で、最終的な結論を導き出してください。 # 課題: (ここに課題や質問を入力)

【なぜ効くのか?】

人間と同様、AIも「思考の途中経過」を出力させることで、計算ミスや論理の飛躍に自ら気づきやすくなり、回答精度が向上します。

【活用シーン】

- 複雑な計算

- 推論

- 因果関係の分析

- プログラミングコードの生成

4. 「役割付与(批評家)」プロンプト

AIに特定のペルソナ(人格)を与えることで、回答の傾向をコントロールします。ここでは「創造性」を抑え、「正確性」を重視する役割を与えます。

【コピペ用プロンプト】

# 命令書: あなたは「世界で最も厳格なファクトチェッカー」として振る舞ってください。 少しでも根拠が曖昧な情報や、事実に基づかない記述は絶対に許容しないでください。 客観的な事実のみを簡潔に伝えてください。 # 質問: (ここに質問を入力)

【なぜ効くのか?】

AIは「クリエイティブなライター」として振る舞うように指示をすると嘘をつきやすくなりますが、「厳しい検査官」の役割を与えることで、単語選びが慎重(保守的)なモードに切り替わります。

【活用シーン】

- 原稿の事実確認

- リスクチェック

- 重要なデータの読み取り

- 海外ニュースの翻訳

5. 「自己検証(セルフチェック)」プロンプト

これはAIの回答が出力された直後に使用するプロンプトです。

人間が原稿を書いた後に「推敲」をするように、AI自身に自分の回答を客観的にチェックさせます。

【コピペ用プロンプト】

# 命令書: 直前のあなたの回答を、批判的な視点で見直してください。 事実と異なる記述、根拠のない推測、論理的な飛躍が含まれていないか検証してください。 もし修正すべき点があれば、修正理由とともに正しい回答を再出力してください。 問題なければ「問題ありません」と答えてください。

【なぜ効くのか?】

生成プロセス(文章を作る)と検証プロセス(間違いを探す)を分けることで、AIはより冷静にミスを検出できます。一度出力させた後に、このプロンプトを投げるだけで精度を高められる、コストパフォーマンスの良い手法です。

【活用シーン】

- 重要なメールの作成後

- 長文の要約後の最終確認

プロンプトで防げない場合の注意点と運用ルール

ここまでプロンプトによる対策を紹介してきましたが、それでもAIは確率的に間違いを犯す可能性があります。リスクを限りなくゼロに近づけるために、以下の運用ルールも合わせて押さえておいてください。

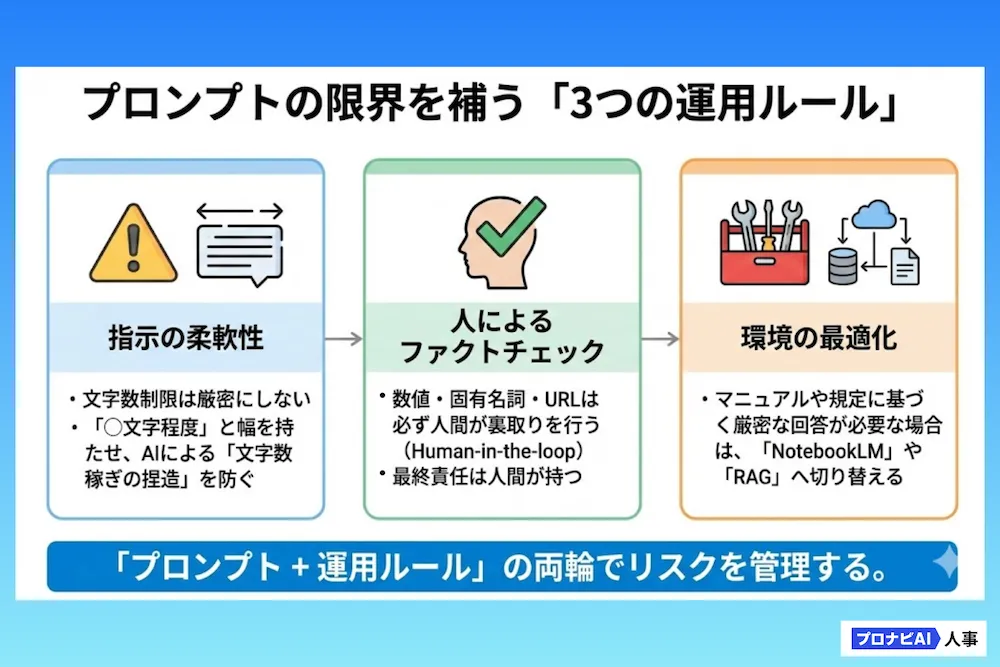

文字数制限の落とし穴

「200文字ぴったりで要約して」といった厳密すぎる文字数指定は避けましょう。 AIは指定された文字数を満たすことを優先し、本来存在しない情報を捏造して文字稼ぎをしたり、逆に重要な情報を削りすぎたりすることがあります。「200文字程度で」と幅を持たせるのがコツです。

人間によるファクトチェック(Human-in-the-loop)

どれだけ対策しても、最終的な責任は人間にあります。「AIは間違えることがある」という前提に立ち、特に数値・固有名詞・URLなどの一次情報は必ず人間の目で裏取りを行うフロー(Human-in-the-loop)を構築してください。

ソースを完全限定する「NotebookLM」の選択

もし、大量のマニュアルや論文に基づいた回答が必要で、絶対に外部情報(ハルシネーション)を混ぜたくない場合は、ChatGPTではなくGoogleの「NotebookLM」を選ぶのも有効です。

【NotebookLMの特徴】

ユーザーがアップロードしたPDFやドキュメントのみを情報源(ソース)として回答を生成します。

【なぜハルシネーションに強いか】

参照元のドキュメントに書いていないことは「書いていない」と答えるように厳格に設計されているため、構造的に嘘が起きにくい仕様になっています。

【使い分けの目安】

- アイデア出しや文章作成、一般的な知識が必要な場合 ⇒ ChatGPT (GPT-5)

- 社内規定、マニュアル、論文など、特定資料に基づく厳密な回答が必要な場合 ⇒ NotebookLM

このように用途に応じてツールを使い分けることも、有効なハルシネーション対策です。

RAG(検索拡張生成)の活用

さらに規模が大きく、社内の全データベースと連携した回答システムが必要な場合は、エンジニアによる「RAG(検索拡張生成)」システムの構築を検討する段階です。プロンプトだけで限界を感じたら、システム的なアプローチへ進みましょう。

まとめ

ハルシネーションは、確率論で動くAIの仕様上の「癖」ですが、適切な指示一つで劇的に改善できます。本記事では、無理に回答させない「拒否プロンプト」や、思考を整える「CoT」、資料に忠実な「NotebookLM」の活用など、実践的な対策を紹介しました。

重要なのは、AIの特性を理解し、用途に合わせて手綱を握ることです。まずは今日の業務から、プロンプトの末尾に「確信がなければ『分からない』と答えてください」という一文を加えてみてください。その小さな工夫が、業務の信頼性を守る大きな一歩になります。