この記事で分かること

- ハルシネーションやバイアスが引き起こす具体的な企業の損失事例

- なぜAI事故が起きるのか、その根本的な3つの原因

- あなたの会社をAIリスクから守るための具体的な3つの対策ステップ

世界企業のAI失敗事例 損失タイプ別・最新ケーススタディ

実際の失敗事例を「損失の種類」で分類し、何が起きてどんな損失に繋がったのかを具体的に解説します。

タイプ1:ハルシネーション(AIの嘘)が招いた「信用の失墜」と「金銭的損失」

AIが事実と異なる情報を生成する「ハルシネーション」。これが引き起こした損失は、企業の信用と財務を直撃します。

事例①:顧客対応ボットが企業に賠償を命じた事例

カナダの航空会社「エア・カナダ」の顧客対応チャットボットは、運賃割引に関する架空のポリシーを顧客に提示しました。誤った情報を信じた顧客が返金を要求したところ、企業側は「AIがハルシネーションを起こした」と主張して返金を拒否。しかし、裁判所は「顧客がチャットボットの情報を信用するのは合理的である」として、企業に812.02カナダドル(約8.8万円)の賠償を命じました。

この事例は、AIの回答がそのまま企業の公式見解と見なされ、法的な責任につながることを明確に示しています。

参考URL:

事例②:弁護士がAIの生成した「存在しない判例」で制裁を受けた事例

米国の法律事務所で、弁護士が生成AIに過去の判例を質問したところ、AIが実在しない判例を生成しました。弁護士がその架空の判例を法廷で引用した結果、裁判所から制裁を受けました。これにより、弁護士個人のみならず、法律事務所全体の信用が失墜し、業務の進め方やAI利用ガイドラインの見直しを余儀なくされました。

この事例は、専門性の高い分野におけるAIのハルシネーションが、法的責任や信用の重大な毀損に直結するリスクを浮き彫りにしています。

参考URL:

事例③:AIが生成した宣伝画像がイベントを「炎上」させた事例

英スコットランドで開催されたイベント「ウィリーのチョコレート体験」では、AIが生成したと見られる夢のような宣伝画像とはかけ離れた、殺風景な会場が来場者を失望させました。多くの来場者が返金を要求し、警察沙汰に発展。この一件はSNSで瞬く間に拡散され、運営会社は大きな批判を浴びました。

過度なAI生成コンテンツの利用が、顧客体験の著しい低下とブランドイメージの毀損に繋がる典型的なケースとして、世界中で報道されました。

参考URL:

タイプ2:アルゴリズムの"偏見"が招いた「差別問題」と「機会損失」

AIが学習データに内在する偏見を取り込み、採用や人事評価において差別的な判断を下すリスクは、組織のダイバーシティを損ない、優秀な人材の獲得機会を奪います。

タイプ3:従業員の"うっかり"が招いた「情報漏洩」

AIの進化は、サイバー攻撃の高度化にも繋がっています。従業員のちょっとした不注意が、企業の機密情報を危険に晒すケースも出てきました。

事例⑤:ディープフェイク詐欺により数十億円が詐取された事例

AI技術の進化は、ハルシネーションだけでなく、悪意のある目的での利用リスクも高めています。2024年初頭には、香港の多国籍企業が、ディープフェイクのビデオ通話で「上司」に扮した詐欺師から送金指示を受け、2,500万ドル(約39億円)以上を詐取される被害に遭いました。

同様のディープフェイク詐欺はシンガポールでも発生し、7,000万円規模の被害が出ています。これは、AIが生成する偽情報が、企業のシステムや財務に直接的な脅威をもたらす現実的なリスクであることを示しています。

参考URL:

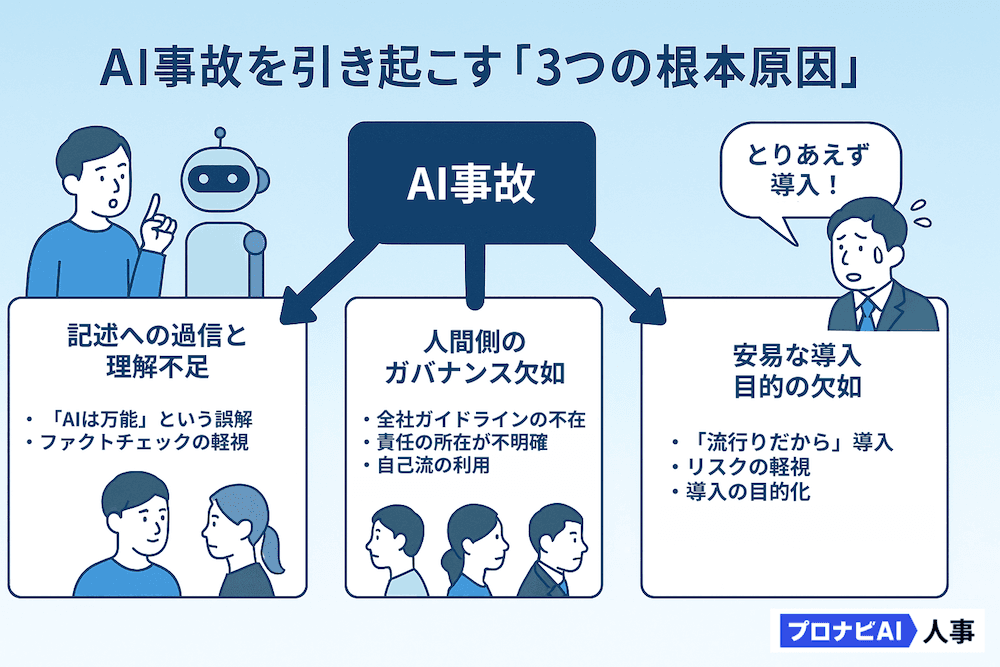

なぜ「AI事故」は起きてしまうのか?

これらの個別の事象の裏には、共通の根本原因が存在します。貴社のAI活用に潜むリスクを特定するために、以下の3つの原因を自己診断してみてください。

原因①:技術への過信と理解不足

「AIは常に正しい」「AIの回答をそのまま使っても問題ない」という誤解が蔓延していませんか?

ハルシネーションやバイアスの仕組みを理解せず、AIの回答を鵜呑みにすることで、上記のような事故が発生しています。AIは万能ではなく、学習データに依存し、誤りを犯す可能性がある不完全なツールであることを理解することが出発点です。

原因②:人間側のガバナンス欠如

全社的なAI利用ガイドラインは策定されていますか?

従業員がそれぞれ「自己流」でAIを利用していませんか?リスク管理部門や法務部門がAI導入の議論から蚊帳の外に置かれていないでしょうか。AI利用の責任の所在が曖昧なままでは、事故が発生した際に誰も責任を取れない「無責任体制」に陥ってしまいます。

原因③:安易な導入と目的の欠如

「競合もやっているから」「流行っているから」という理由だけでAIを導入していませんか?

AIに何をさせたいのか、その結果どんなリスクが発生し得るのかを精査しないまま、導入すること自体が目的化してしまっているケースが散見されます。目的が曖昧なままでは、リスクの特定も対策も後手に回ってしまいます。

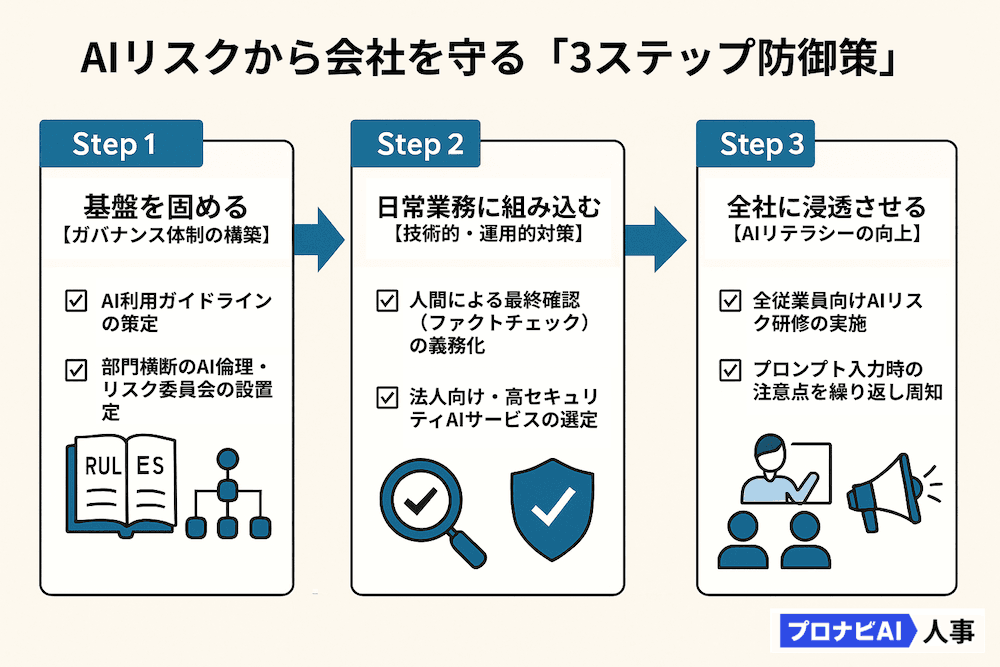

あなたの会社を「AIによる損失」から守るための対策

監修者 前川氏のコメント

AIは便利で効率的であり、一度ビジネスがAI最適化されれば、そこから離れるのが困難になるでしょう。しかし、その一方でAIによる被害事例も今後多数出てくると考えられます。社会全体のAI浸透が進めば進むほど、そこで発生する被害は甚大になります。企業や社会がAIにどこまでの責任を負わせるのか、このような哲学的な議論をより一層深める必要があります。

裁判、医療、そして政策といった分野でもAIの活用は進んでいます。当初は補助的な役割であったものが、将来的にはAIが最終判断まで担うようになるでしょう。この状況において、「本当にそれで良いのか?」「人間はどこまで関与すべきなのか?」といった、より深い哲学的な問いが問われることになります。

AIの社会浸透はまだ序盤であり、当面は様々なトラブルが発生するでしょう。しかし、この流れが止められない以上、私たちは実践と並行して制度を整備していくしかありません。そのためには、企業や個人がAIリスクに対するリテラシーを高め、適切なガバナンス体制を構築することが不可欠です。