【この記事でわかること】

- 世界の主要企業におけるAI利活用ガイドラインの共通原則

- 日本企業が取るべきAIガバナンス整備の実践ステップ

各国におけるAI利活用ガイドライン策定の事例紹介

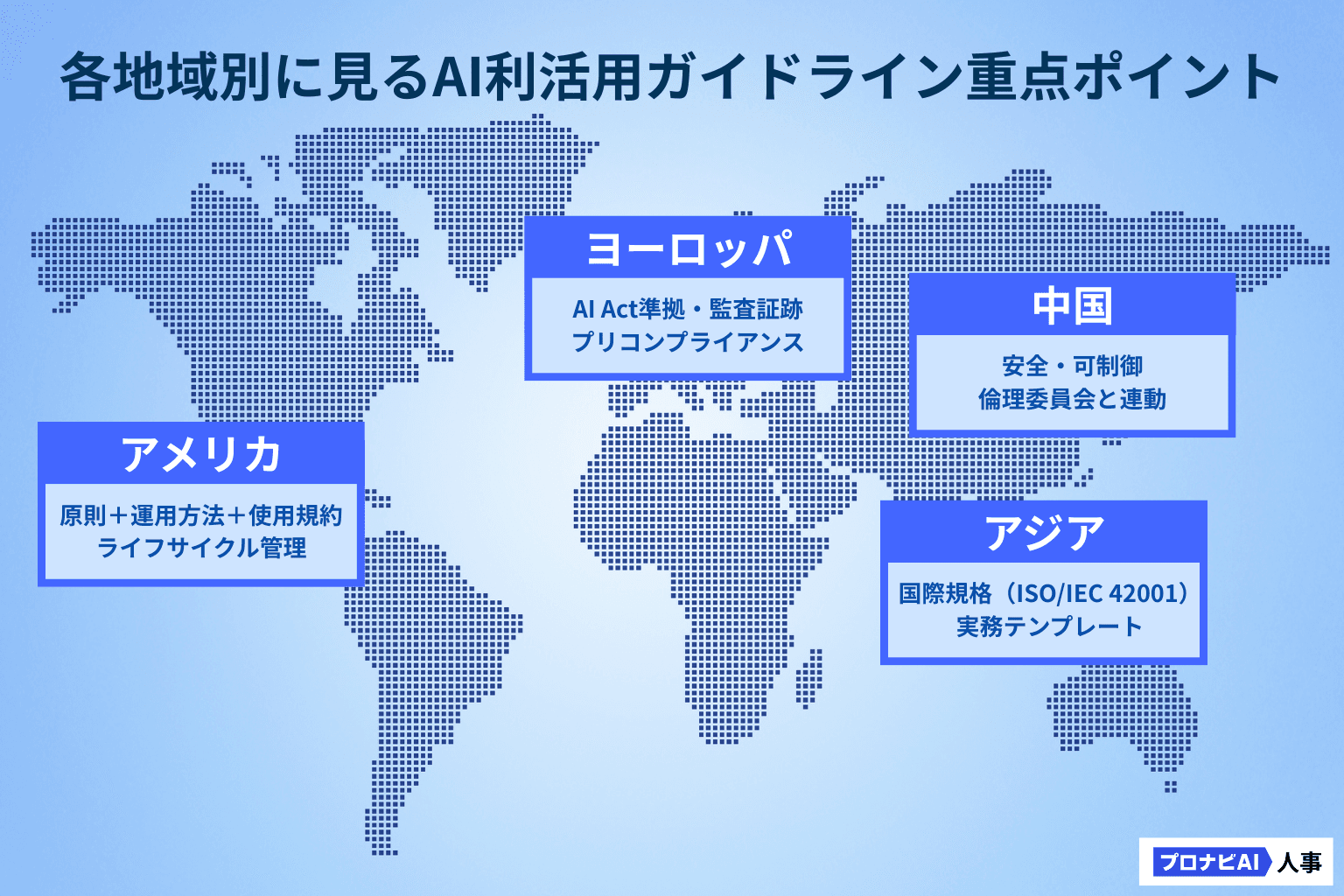

米国

米国企業は「原則+具体的な運用方法+使用規約」を三位一体で提言、モデル能力の高度化に応じて定期改訂するのが特徴です。AIの導入から利用・管理まで、一連のプロセス全体で透明で、公平で、安全であることを徹底する点が共通しています。

Microsoft

「Responsible AI Standard v2」(2022年策定)。ライフサイクルの各工程で、透明性・公平性を確保し、人による管理を義務付ける。

「AI Principles」(2018年公開)および「Responsible AI Progress Report」(2024年・2025年更新)。研究から運用まで、一貫したリスク管理を行い、年次で報告する。

OpenAI

「Preparedness Framework v2」(2025年4月改訂)。高度で多用途に使えるAIの能力と悪用リスクを定量的に評価し、緩和策を段階的に実装する。

Anthropic

「Responsible Scaling Policy(RSP)」(2023年策定、2025年改訂)。AIの能力に応じて安全基準を強化する仕組み『AI Safety Levels(ASL)』を導入する。

Salesforce

「AI Acceptable Use Policy」(2023年策定、2025年8月改訂)。高リスクの用途を禁止し、AIが介在している場合は開示を契約で定める。

Adobe

「Content Credentials(CAI/C2PA)」(2023年導入)。生成物に真正性を示す情報を与え、出所や改ざんを確認できる仕組みを標準化する。

中国

中国の大手企業は『安全・可制御(Safe & Controllable)』を最上位の原則とし、ESGや倫理委員会と連動させている点が特徴です。

Baidu

「AI Ethics Principles」(2019年策定、ESG報告に組み込み)。安全と公平を含む四つの原則を定め、戦略目標とした。

Tencent

「ARCC原則」(2018年策定)。Available(可用性)/Reliable(信頼性)/Comprehensible(明瞭性)/Controllable(制御可能性)の4軸を定義。

Alibaba

「AI Ethics Principles」(2022年公開)。プライバシー保護・説明可能性・セキュリティを重視し、倫理委員会が監督する。

SenseTime

「Code of Ethics for AI Sustainable Development」(2019年策定)。人間中心・持続可能・制御可能を原則に掲げ、倫理委員会を設置する。

欧州

欧州企業はEUのAI Act(※)を見据え、方針の表明に加えて実装マニュアルや監査証跡を整備する『プリコンプライアンス』が進んでいます。

※AI Act:EUが2024年に制定した世界初の包括的なAI規制法。リスクに応じてAIを分類し、高リスク用途には透明性や安全性の確保を義務付ける。

SAP

「Global AI Ethics Policy / AI Ethics Handbook」(2022年策定、2024年更新)。UNESCO勧告に整合させ、手順・役割・記録を明文化する。

Bosch

「Code of Ethics for AI」(2020年策定)。人間が最終決定者であることを明記する。

Mistral AI

「Terms of Service」(2025年5月施行)。利用規約において、ユーザーの規律とモデレーションの基準を明確化。

Stability AI

「Safety Policy」(2023年策定)。オープンモデルの提供にあたり、安全性評価と悪用防止策を公開。

アジア・インド・豪州

この地域の企業は、現場で活用できるテンプレートや国際規格ISO/IEC 42001との接続を重視しています。

Grab(シンガポール)

「AI Ethics Principles」(2023年策定)と「AI Risk Framework」(2024年公開)。リスクの特定から緩和、監視までの手順を明示。

Infosys(インド)

「Responsible AI Principles」(2024年公開)。ISO/IEC 42001:2023に準拠し、AIマネジメントシステム認証を取得。

Atlassian(豪州)

「Responsible Technology Principles」(2024年策定)。審査テンプレートを公開し、EU AI Actのプリコンプライアンスを推進。

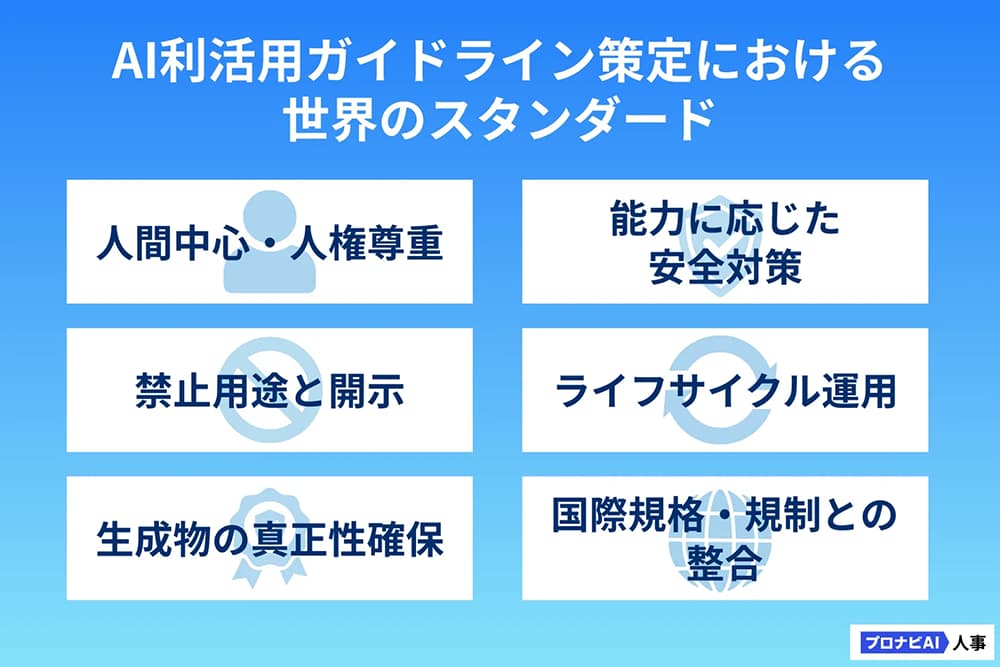

AI利活用ガイドライン策定における世界のスタンダード

海外の先行事例を整理すると、各社が共通して押さえている実務の必須ポイントは次の6つに集約されます。

人間中心・人権尊重

AIの判断に頼り切らず、最終的な意思決定は人間が行う。

ライフサイクル運用

AI導入の流れ(設計 → 学習 → 評価 → 運用 → 監視)ごとに責任者・基準・記録を明確にし、更新のたびに再評価する。

能力に応じた安全対策

高度なAIほどリスクも大きいため、モデルの能力に応じて安全要件を強化する。

禁止用途と開示のルール化

AIの使い方で「やってはいけないこと」を明示し、生成物にはAIが関与したことを開示する。

生成物の真正性確保

AIで作られた画像や文書に「出所」や「編集履歴」を埋め込み、後から確認できるようにする。

国際規格・規制との整合

ISO/IEC 42001(AIマネジメント規格)やEU AI Actなど、世界標準に沿っておくことで監査対応や海外取引がスムーズになる。

次に、日本がこうした潮流を踏まえ、どのような対応を講じるべきかを見ていきます。

世界の潮流に対し、日本はどう動くべきか

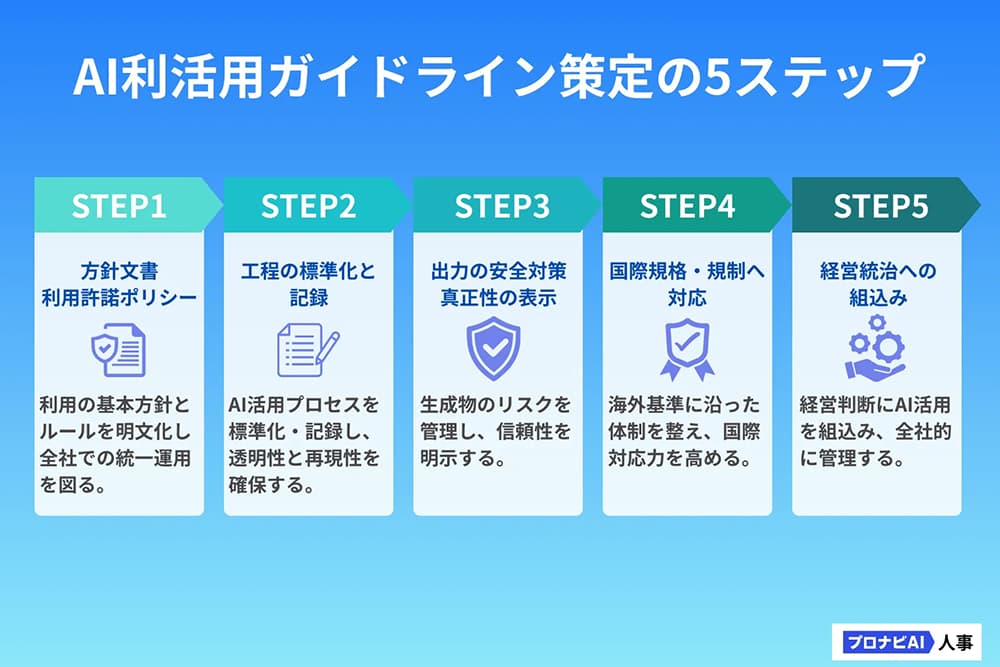

最短で運用できるAI利活用ガイドラインに着地させるためには、以下の5つのステップで段階的に整備していくのがおすすめです。

STEP.1 方針文書+利用許諾ポリシーをまず用意する

国内外の取引先や顧客から「AIの利用ポリシーを開示してほしい」と求められる場面が増えています。特に海外取引がある企業では英語版の提示が不可欠のため、英文での表記も求められます。

具体的な方法

- 「人権・安全・公平・透明性」の4原則を冒頭で明示。

- AIを利用する際の「禁止用途(例:差別的利用、医療診断の無断代替、監視用途など)」を列挙。

- 「AIが関与して生成した成果物である場合は明示する」ルールを加える。

STEP.2 AI導入の全工程を標準化し、判断の記録を残す

AIを導入する際は、プロセスごとに「誰が・どこで・どのように判断したか」を記録しておかないと、不具合や事故が起きたときに説明できなくなります。

具体的な方法

- 工程を「要件定義 → 設計 → 学習 → 評価 → 展開 → 監視 → 廃止」に分ける。

- 各工程で「責任者」「判定基準」「記録フォーマット」をセット化。

- 記録はWord/Excelでもよいが、後で監査できる形(改ざん防止のログ)にするのが望ましい。

STEP.3 AI出力の安全対策と真正性の表示を組み込む

AIが出力する内容には、誤情報・差別的表現・著作権侵害といったリスクが含まれる可能性があります。

そのため、安全対策に加えて「生成物の信頼性表示」を導入することが重要です。こうした仕組みは国際的にも広がりを見せています。

具体的な方法

- 入力フィルタ:社内秘情報や個人情報をAIに入力できないよう制御。

- 出力フィルタ:NGワードや特定カテゴリ(暴力・差別など)を検知。

- 来歴表示:社外に出す画像や文書はAdobeの「Content Credentials」のように「AI生成物であること」をメタデータとして付与。

STEP.4 国際規格と規制への先行対応で競争力を高める

海外市場をターゲットとする企業にとっては、現地の規制や認証に先行して対応することが重要です。早めに取り組むことで、取引や提案の場で「安心できるパートナー」と評価され、競争優位につながります。

具体的な方法

- ISO/IEC 42001:2023(AIマネジメントシステム規格)の準拠を目標に設計。

- EU AI Actを意識し、「リスク分類」「高リスク用途の追加審査」を社内ルールに反映。

STEP.5 AI方針を経営統治に組み込み、実効性を高める

AI方針を「情報システム部のルール」にとどめてしまうと形骸化しかねません。経営レベルに組み込むことで、方針の実効性と継続性を確保できます。

具体的な方法

- ESG報告書に「AIガバナンス指標(KPI)」を盛り込み、株主や投資家にも開示。

- 社内に「AI倫理委員会」を設置し、年1回以上のレビューと改訂を必須化。

- KPI例:「AI利用案件の審査件数」「禁止用途違反の発生件数」「開示付き生成物の割合」

まとめ

海外の先進企業は、AI活用のルールを単なるお題目にせず、「実際に運用できる仕組み」として整えています。

具体的には、方針や原則を示すだけでなく、社内の作業プロセス、契約の取り決め、生成物の信頼性を示す仕組み、記録の残し方まで、一式で用意し、状況の変化に応じて定期的に見直しています。

日本企業がすぐ取り組めるのは、まず 利用許諾ポリシー(AUP)の作成と公開、そして AI活用の流れごとに責任者やチェック方法を決めて記録を残す仕組みを整えることです。

さらに、将来を見据えて 国際規格や海外の規制にあらかじめ対応しておくことで、国内外からの信頼を高めつつ、ビジネスをスピード感をもって進めることができます。