- 日本のAI統一指針「AI事業者ガイドライン」の全体像と最重要8原則

- 情報漏洩・著作権・ハルシネーションの3大リスクを回避するための具体的な禁止事項例

- AIガイドラインを実効性のあるものにするための策定5ステップと実務的アドバイス

【基本理解】全企業担当者が知るべき「AI事業者ガイドライン」の全体像

AI事業者ガイドラインは、経済産業省と総務省が策定したもので、生成AIの普及に伴う法的・倫理的リスクを管理し、安全な社会実装を促すための指針です。企業は、このガイドラインに示された行動原則や留意点を理解し、自社の社内規定や運用ルールに反映させることが求められます。

「AI事業者ガイドライン」とは?統合された最新指針を解説

従来の総務省・経済産業省から発表されていたAI指針は、2024年以降、「AI事業者ガイドライン」として一本化されました。これは、AI技術の急速な進化と社会実装に対応するため、政府が企業のAI利用における共通の羅針盤として提示したものです。

このガイドライン自体には、特定の法令のような法的拘束力はありません。しかし、国際的な動向(G7広島AIプロセスなど)を踏まえたうえで策定されており、企業がAIを安全かつ倫理的に利用し、社会からの信頼性を担保する上での事実上の統一指針として、無視できない重要性を持っています。

特に、AI活用を推進する担当者の皆様にとって、この指針は「自社のAI利用が社会的に見て適切か」を判断するための最も信頼できる根拠となります。

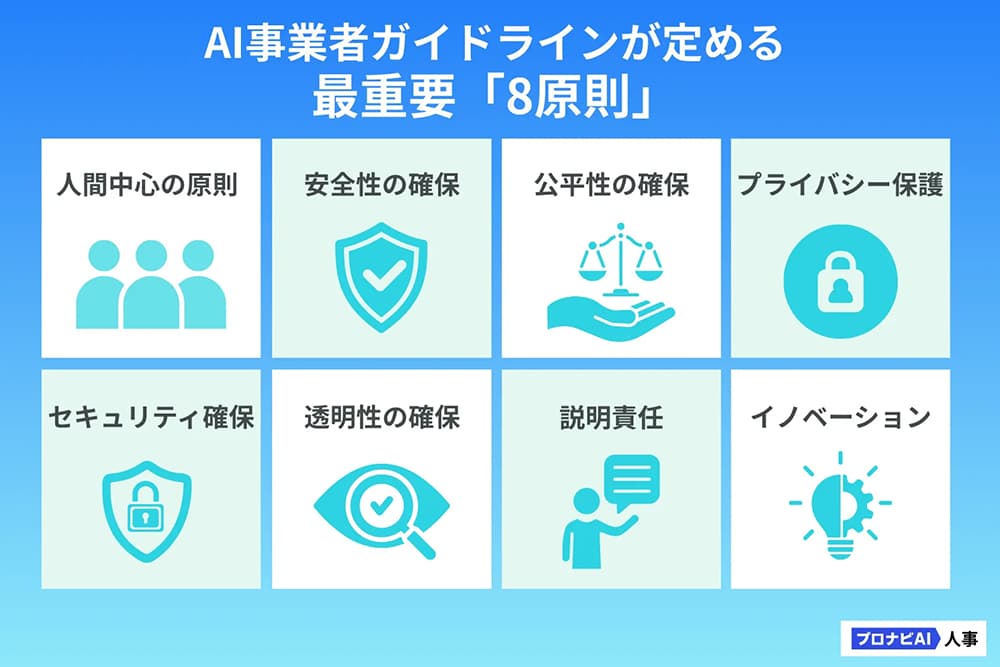

対策必須!AI事業者ガイドラインが定める最重要「8原則」

AI事業者ガイドラインは、AIを開発・提供・利用するすべての事業者が遵守すべき行動規範として、以下の8つの原則を定めています。これらは、社内ガイドラインを策定する際の土台となるため、必ず確認してください。

| 原則 | 概要 | 社内ガイドラインへの反映例 |

|---|---|---|

| 1. 人間中心の原則 | AIは人間の尊厳や権利を尊重し、意思決定の主体は人間に留める。 | 最終的な意思決定はAIに頼らず、必ず人間のチェックを経ることを明記。 |

| 2. 安全性の確保 | AIシステムは安全性を確保し、予期せぬ被害やリスクを最小限に抑える。 | AI利用前に、セキュリティ部門によるリスク評価を義務付ける。 |

| 3. 公平性の確保 | 不当な差別や偏見を回避し、多様な人々の意見を反映する。 | 採用活動など、機微な情報を取り扱うAI利用時は、利用データに偏りがないか確認する。 |

| 4. プライバシー保護 | 個人情報の取り扱いに関して、法令やガイドラインを遵守する。 | 機密情報や個人情報を入力データとして使用することを禁止する。 |

| 5. セキュリティ確保 | サイバー攻撃などからAIシステムとデータを保護する。 | 社内専用のセキュアなAI環境(SaaS型など)の利用を推奨する。 |

| 6. 透明性の確保 | AIの利用目的や性能、判断根拠を可能な範囲で公開・説明する。 | AIで生成したコンテンツには、その旨を明記することをルール化する。 |

| 7. 説明責任 | AIの提供・利用において問題が発生した場合、適切な対処を行う責任を負う。 |

特にプライバシー保護の原則は、機密情報や個人情報の漏洩リスクに直結するため、社内ルールの中で最も厳格に運用すべき項目です。

【実践】実効性のあるAIガイドライン策定5ステップ

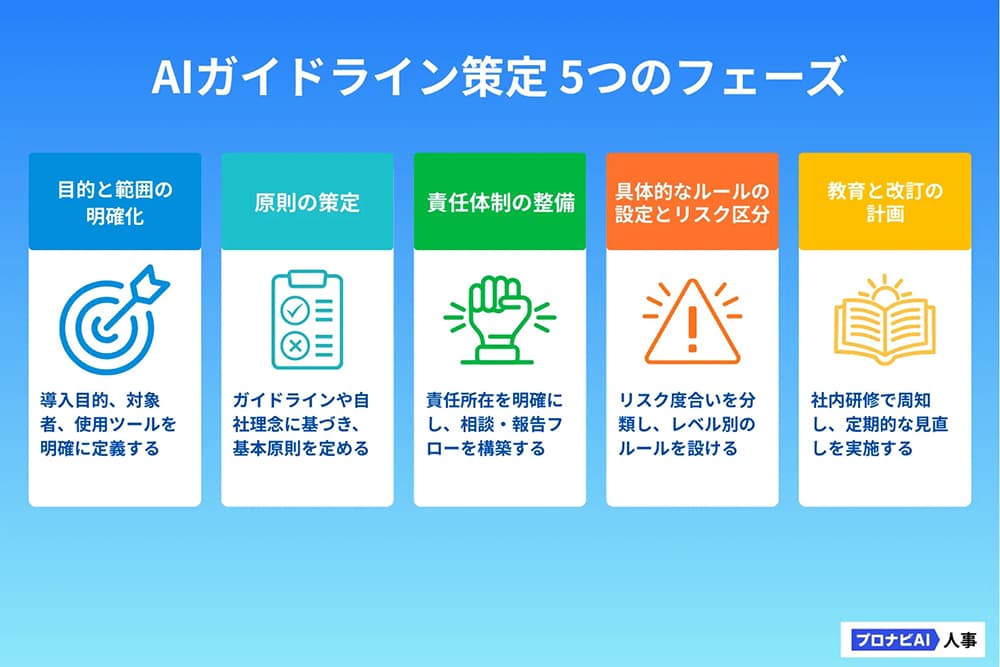

AIガイドラインを策定する際、「完璧なルール」を目指すあまり、必要以上に時間をかけてしまうケースが少なくありません。技術は日々進化しているため、まずは完成度7割でも公開し、運用しながら継続的に改善していく姿勢が重要です。

ここでは、実効性のあるガイドラインを策定するための5つのフェーズと、現場での運用に不可欠な具体的な禁止事項例を解説します。

AIガイドライン策定の全体像:成功のための「5つのフェーズ」

国際的な原則を踏まえつつ、自社の実情に合わせたAIガイドラインを策定するためのステップは以下の通りです。

1. 目的と範囲の明確化

- 何を目的とするのか: 業務効率化、リスク低減、イノベーション促進など

- 誰を対象とするのか: 全従業員、特定の部門、外部委託先など

- どのAIツールを対象とするのか: ChatGPT、Copilot、社内開発AIなど

実務的アドバイス: まずは「情報漏洩」と「著作権」といったリスク回避に焦点を絞り、全従業員が使うであろう汎用的な生成AIを対象としてガイドラインの適用範囲を定めるのが現実的です。

2. 原則(ポリシー)の策定

- 前述の「AI事業者ガイドライン」の8原則を踏まえつつ、自社の経営理念や業界特性(例:金融業なら「説明責任」、製造業なら「安全性」)に合わせた重点原則を明記する

3. 責任体制の整備

- 最終責任者(役員など)と、日常的な運用・審査を担当する部門(法務、情報システム、AI推進室など)を明確にする

- 問題が発生した際の相談窓口と報告フローを具体的に定める

4. 具体的なルールの設定とリスク区分

- 「利用禁止」「高リスク(利用制限あり)」「限定的利用(承認条件あり)」など、AI利用のリスクレベルを分類し、それぞれに対する具体的なルール(特に禁止事項)を定める

- この段階で、最も読者が求めている「禁止事項」の具体例を洗い出す(次項で詳細を解説)

5. 教育と改訂の計画

- 従業員研修やケーススタディを実施し、ルールの周知徹底を図る

- AI技術や関連規制は変化が早いため、定期的な見直し(3ヶ月〜半年ごと)のサイクルを計画する

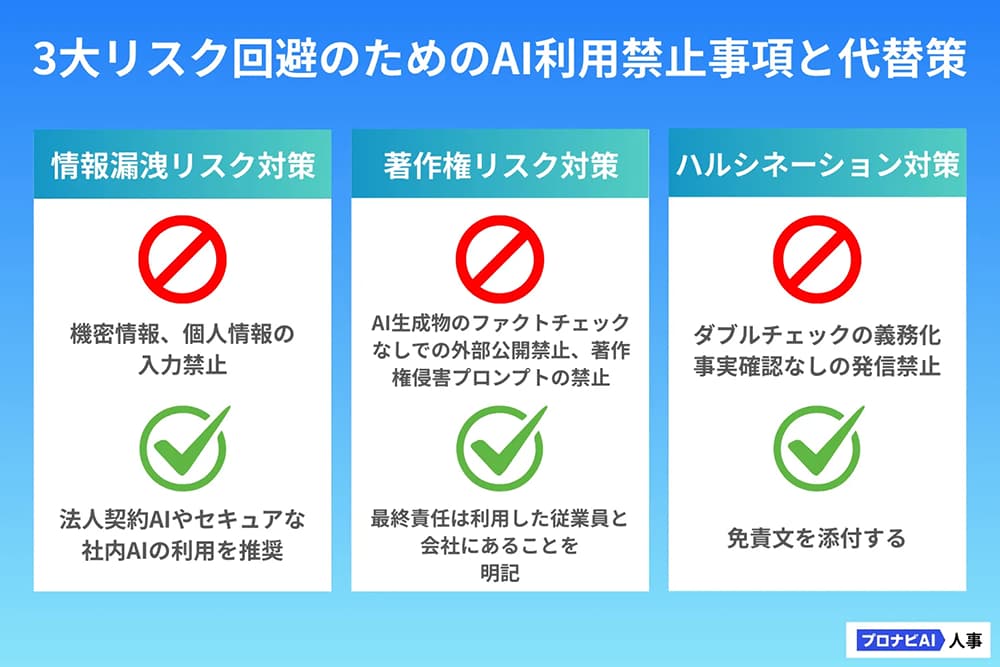

現場の不安を解消!生成AI利用時の「禁止事項とルール」具体例

ガイドラインの中でも、現場の従業員が特に意識し、具体的な行動を変えるきっかけとなるのが「禁止事項」に関するルールです。情報漏洩・著作権・ハルシネーションという3大リスクを回避するために、以下の具体例を参考に自社のルールを策定してください。

1. 【情報漏洩リスク対策】データ入力を禁止するルール

AIの学習モデルに機密情報や個人情報が取り込まれ、意図せず外部に流出するリスクを避けます。

【社外の汎用AI(例:無料版ChatGPTなど)への入力禁止事項】

- 機密情報の入力禁止:顧客データ、未公開の事業戦略、財務情報、営業秘密、社内パスワードや認証情報

- 個人情報の入力禁止:氏名、住所、電話番号、メールアドレス、マイナンバー、人事情報など、特定の個人を識別できる情報

- 特定の契約・法務情報の入力禁止:係争中の案件情報、法的に秘匿性の高い契約書のドラフトなど

【代替策の提示と推奨事項】

- 情報入力が可能な環境の限定:情報を入力する場合は、法人契約の専用AIサービス(学習データとして利用されないことが契約で保証されているもの)や、社内環境に構築されたセキュアなAIシステムのみを利用すること

2. 【著作権リスク対策】コンテンツ生成・利用時のルール

AIが既存の著作物に類似した成果物を生成したり、著作権のあるデータを無断で利用したりするリスクを避けます。

【生成コンテンツの利用に関する禁止事項】

- 生成された文章・画像の「そのまま利用」禁止:AIが生成した成果物(テキスト、画像、コードなど)を、必ず人間がファクトチェックし、編集・加筆することなく、社外に公開することを禁止

- 著作権侵害の可能性があるプロンプトの禁止:特定の有名人やキャラクターの画像を生成させる指示、既存の楽曲や文章を模倣したものを生成させる指示などを禁止

【責任と対策の明確化】

- 最終責任の所在:AIが生成したコンテンツに関する著作権侵害の責任は、最終的にその利用を行った従業員と会社にあることを明記

- 引用元の明記:AI生成物であっても、他者のコンテンツを参考にする場合は、必ず著作権法に基づいた適切な引用元表示を行う

3. 【ハルシネーション対策】情報の信頼性確保のルール

AIが事実とは異なる情報(ハルシネーション)を生成するリスクに対応し、業務上のミスを防ぐことができます。

【情報利用に関する禁止事項と義務】

- 誤った情報の発信禁止:AIが生成した情報に基づき、事実確認なしに顧客や取引先に対して重要な意思決定や情報発信を行うことを禁止

- ダブルチェックの義務化:業務で利用するAI生成情報について、必ず2つ以上の信頼できる情報源(社内データベース、公的機関のウェブサイト、専門家の意見など)と照らし合わせるダブルチェックを義務化

- 「免責文」の添付: AIを利用して作成したメールやレポートには、必要に応じて「本資料の一部にはAIを活用しています。内容の正確性については、最終的に人間が確認しています」といった免責文を添付することを検討

【コピペ可能】すぐに使える「AI利用ガイドライン」

ここでは、すぐに自社のガイドラインに組み込める構成要素と、各章で記載すべき内容のサンプルをご紹介します。法務・システム担当者の手間を大幅に削減できるテンプレートとしてご活用ください。

|

章 |

見出し(例) | 記載すべき主な内容 |

|---|---|---|

| 第1章 | 目的と適用範囲 | 本ガイドラインの目的(安全と推進の両立)と、対象者(全従業員、外部委託先)や対象となるAIツール(汎用生成AI、社内AIなど)を明記する。 |

| 第2章 | AI利用の基本原則と理念 | AI事業者ガイドラインの8原則など、企業として重視する基本理念を簡潔に記載。(人間中心、プライバシー保護、公平性など) |

| 第3章 | 利用ルールと禁止事項 |

|

| 第4章 | 責任体制と報告フロー | AI利用に関する最終責任者、ガイドラインの所管部門、従業員からの相談窓口、インシデント発生時の緊急連絡先と報告手順を明記する。 |

| 第5章 | 教育・監査と継続的改善 |

従業員への定期的な研修の実施、利用状況のモニタリング(ログ監査)、ガイドラインの定期的な見直しと改訂サイクルを定めます。 |

【実務的アドバイス】

従業員に負担なく浸透させるため、「対外公開用(簡潔版・1〜2ページ)」と「社内利用詳細版(実務ルール)」の二層構造でガイドラインを作成すると、運用が格段に容易になります。

運用・定着フェーズ:現場に浸透させるAIガバナンス構築術

ガイドラインは策定して終わりではなく、現場で活用されて初めて真価を発揮します。ここでは、ルールを定着させ、継続的に改善していくためのポイントをご紹介します。

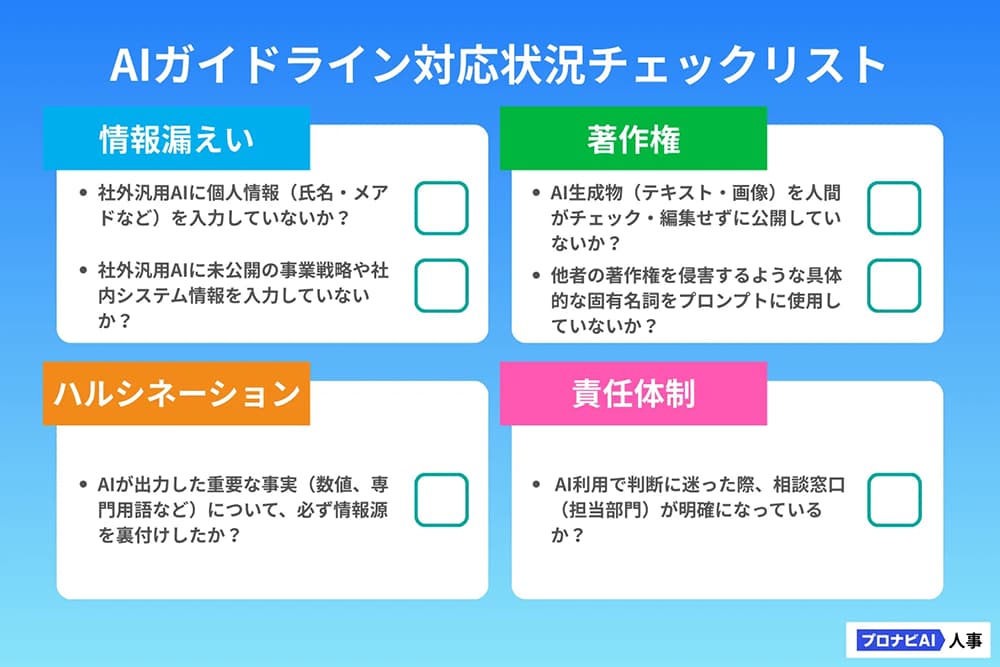

AIガイドライン対応状況チェックリストと活用法

策定したガイドラインが現場に浸透しているか、またリスクへの対応が適切に行われているかを測るには、チェックリストの活用が有効です。これは、単なるルール遵守の確認に留まらず、従業員の「AIリテラシー研修」の一部として活用できます。

チェックリスト活用法

- 部署ごとの定期的な自己診断: 月に一度、各部署でこのチェックリストを用いて自己診断を行い、その結果をAI推進部門に報告する

- リスクスコアリング: 「No」の数が多かった部署に対して、個別研修を実施するなど、リスクの高い領域から優先的にフォローアップを行う

先進事例:AIガバナンスを継続的に改善する「アジャイル・ガバナンス」

AI技術やその利用実態は日々めまぐるしく変化しているため、一度作ったガイドラインを何年も見直さずにいると、すぐに実態と合わなくなってしまいます。

そこで重要となるのが、「アジャイル・ガバナンス」という考え方です。これは、ソフトウェア開発の手法である「アジャイル」(迅速な開発と改善を繰り返す)をガバナンス(ルールづくりや運用の仕組み)に応用したもので

| 項目 | 従来型ガバナンス(ウォーターフォール) | アジャイル・ガバナンス |

|---|---|---|

| 策定頻度 | 数年〜に一度の頻度で「完璧な」ルールを目指す | AIの進化や社内活用状況に応じて、短期間(数ヶ月単位)でルールを柔軟に見直す |

| ルールの性質 | 原則禁止をベースに、例外的に許可する | 原則許可をベースに、リスクの高い利用法を例外的に禁止・制限する |

| 重点項目 | 法的責任回避とリスク低減 | 革新の促進と業務改善の最大化(ただし、法的リスク管理も両立) |

AI推進の担当者は、「完璧なルールを待つよりも、現場の試行錯誤を許容し、そのフィードバックを基にルールを柔軟に改善していく」という姿勢で臨むことが、AI活用のスピードを落とさないための鍵となります。

AI活用にガイドラインがない場合のリスク

AI活用に関する方針を整備しない場合、企業は具体的にどのようなリスクに直面するのでしょうか。

ここでは、実際に海外で起きた事例をもとに、ガイドライン不在によってどのような問題が生じうるのかを見ていきます。

実際のリスク事例

Air Canadaの事例

公式サイトのチャットボットが弔慰割引の条件について誤った案内をしたことで、企業側の説明責任が問われました。裁判所は「AIの回答であってもウェブサイト上の情報に責任を持つのは企業である」と判断。過失による誤導として運賃差額等の支払いを命じました。これにより、AIの出力結果に対しても人間と同様の法的責任が生じることが明確になりました。

Arup香港の事例

ディープフェイク技術を悪用したオンライン会議により、香港オフィスの社員が約2,500万ドルの巨額送金を行ってしまった詐欺事件。会議にはAIで生成されたCFOなどの幹部が複数登場しており、視覚・聴覚情報の偽装を見抜けなかったことが被害につながりました。この件は、AI時代のなりすまし対策として、多要素認証や承認フローの厳格化といった内部統制の重要性を強く警鐘を鳴らしています。

これらのケースが示すのは、ガイドラインは「従業員を縛るルール」ではなく「企業を守る盾」であるということです。トラブルが発生してから対応するよりも、事前にルールを整備しておく方が、対応コストを大幅に抑えられ、企業としての信頼低下も防ぐことができます。

参考

- Air Canada found liable for chatbot's bad advice on plane tickets|CBC

- 「チャットボットの誤回答に責任はない」と弁解していたエア・カナダに裁判所が損害賠償支払いを命令|Gigazine

- British engineering giant Arup revealed as $25 million deepfake scam victim|CNN

- Finance worker pays out $25 million after video call with deepfake ‘chief financial officer’|CNN

- ディープフェイク上司の指示に従い38億円を詐欺師に送金してしまう事態が発生、ディープフェイクを見分ける方法はあるのか?|Gigazine

国内主要組織によるAI活用ガイドライン・ポリシー公開事例

1. 【IT】ソフトバンク株式会社

グループ全体で生成AIの利活用を推進しており、倫理的な側面と実務的なリスク管理の両面をカバーした詳細なポリシーを公開しています。

特徴:「人間中心」「公平性の尊重」「透明性と説明責任」など、AI事業者ガイドラインの柱となる考え方を網羅。AIの判断根拠の検証可能性や、社会的マイノリティへの配慮など、実運用に即した倫理基準を明確にしています。

参考

ソフトバンクAI倫理ポリシー|ソフトバンク株式会社

2. 【メーカー】パナソニック ホールディングス株式会社

製造業として「責任あるAI」の実現を目指し、グループ全体で遵守すべきAI倫理原則を策定しています。

特徴: AIの開発・利用の全工程において、人権の尊重や安全性の確保を最優先。特に、AIの判断結果が人々に及ぼす影響を考慮した設計方針や、適正な利用を促すための社内審査体制の構築についても触れています。

参考

パナソニックグループ AI倫理原則|パナソニック ホールディングス株式会社

3. 【メーカー】ソニーグループ株式会社

世界に先駆けてAI倫理に取り組んでおり、製品・サービスへのAI搭載を前提とした高度なガバナンス体制を構築しています。

特徴: ステークホルダーとの対話や、プライバシー保護、公平性の尊重を重視。AIが意図しない結果をもたらす可能性を認めた上で、生命・身体・財産を脅かさないための品質検証や、正確な情報の提供を徹底する方針を掲げています。

参考

責任あるAIの取り組み|ソニーグループ株式会社

4. 【行政】東京都

自治体における生成AI活用の先駆的なモデルとして、具体的な利用マニュアルを含むガイドラインを一般公開しています。

特徴: 庁内での利用ルール(個人情報の入力禁止など)だけでなく、プロンプトの例や、行政ならではの正確性担保の方法などが詳細に記載されています。

参考

文章生成AI利活用ガイドライン|東京都

まとめ

本記事では、AI活用を推進するうえで避けて通れないリスクに対応するため、日本の統一指針である「AI事業者ガイドライン」をベースにした、実効性のある社内ルール策定の全体像を解説してきました。重要なのは、ガイドラインを「従業員を縛るルール」ではなく、「企業と従業員を守り、イノベーションを後押しする仕組み」として位置づけることです。

まずは「情報漏洩」「著作権」「ハルシネーション」の3大リスクに対する具体的な禁止事項を定め、社内に周知するところから始めましょう。

そして策定後も「アジャイル・ガバナンス」の視点を取り入れ、現場のフィードバックをもとに継続的な見直しと改善を行ってください。安全性と推進を両立させるための道筋が見えた今こそ、過度にリスクを恐れず、前向きにAI導入の次ステップへと進み出す好機です。