生成AI導入で企業が直面する主なリスク

生成AIを業務で活用する際には、さまざまなリスクが伴います。まずは企業が直面する主要なリスクを把握しましょう。大きく「インプット」「アウトプット」「セキュリティ」「運用」の4カテゴリに分けられます。

1. インプットのリスク

情報漏えい・プライバシーリスク

従業員がプロンプト(指示文)に、社外秘の会議議事録、顧客の個人情報、開発中のソースコードなどの機密情報を入力してしまうケースです。

特に無料版の生成AIは、利用規約で「入力データをAIの学習に使用する」とされていることが多く、一度学習データに取り込まれると、他ユーザーへの回答に反映される可能性があります。

2. アウトプットのリスク

著作権・知的財産権リスク

生成AIは、学習データに含まれる既存の著作物(文章・画像・コード)と似たコンテンツを出力することがあります。従業員が確認せずにブログ記事や製品デザインに流用すると、他社の著作権や知的財産権を侵害し、訴訟リスクにつながります。

不正確情報(ハルシネーション)リスク

ハルシネーション(幻覚)とは、事実に基づかない「もっともらしい嘘」をAIが自信満々に生成する現象です。

AIの回答を鵜呑みにすると、誤った情報に基づいた経営判断や顧客への誤回答など、重大な業務リスクが発生します。

偏見・バイアスリスク

AIはインターネット上のテキストデータを学習するため、性別・人種・思想などの偏見を含む場合があります。採用や評価にAIを活用すると、無意識に差別的判断をしてしまい、企業の信頼やブランドを損なう可能性があります。

3. セキュリティのリスク

サイバー攻撃・脆弱性リスク

悪意のある第三者が、生成AIをサイバー攻撃に悪用するリスクです。

- より巧妙で自然な日本語のフィッシングメールを大量に作成する

- マルウェア(ウイルス)のコードを生成させる

- システムの脆弱性を見つけさせる

また、「プロンプトインジェクション」と呼ばれる攻撃手法も脅威です。これは、特殊な指示文(プロンプト)を入力することで、AIのセキュリティ設定を回避し、開発者側が意図しない動作(例:機密情報を盗み出す)をさせる攻撃です。

4. 運用時のリスク

シャドーITとガバナンス欠如

企業の情シス部門が許可していない無料のAIツールを、従業員が利便性のために個人アカウントで勝手に業務利用してしまう「シャドーIT」のリスクです。

管理部門が利用実態を把握できないため、機密情報の入力や、セキュリティが脆弱なツールからの情報流出など、企業のガバナンスが全く効かない危険な状態に陥ります。

AI依存によるスキル低下

文章作成や要約、プログラミングをAIに頼りすぎると、従業員の思考力やスキルが中長期的に低下する可能性があります。AIはあくまで「副操縦士」であり、最終的な判断やクリエイティブな思考は人間が担う意識付けが重要です。

生成AIのリスクが表面化した事例とヒヤリハット

リスクを「自分ごと」として捉えるため、実際に発生した(あるいは報じられた)「典型的なシナリオ」と「具体的な事例」を4つ紹介します。

1. 機密情報の入力による情報漏洩

従業員が業務効率化のために、社外秘の会議議事録や開発中のソースコード、顧客情報などを安易に無料のAIサービスに入力してしまうケースです。AIがそのデータを学習し、外部に流出するリスクが懸念されます。

【実例】

2023年、韓国Samsung電子の従業員が、半導体設備の測定データやソースコードをChatGPTに入力してしまったと報じられました。これを受け同社は、社内でのAI利用を制限する措置を取る事態となりました。国内でも同様のヒヤリハットが多発しています。

参考URL:

https://forbesjapan.com/articles/detail/

2. ハルシネーション(嘘)の鵜呑みによる業務ミス

AIが生成する「もっともらしい嘘(ハルシネーション)」を、利用者がファクトチェックせずに鵜呑みにしてしまい、業務上の重大なミスに繋がるケースです。

【実例】

2023年、米国の弁護士が、訴訟準備のためにAIに判例をリサーチさせたところ、AIが生成した「存在しない架空の判例」をそのまま裁判所に提出してしまい、制裁を科される事態となりました。これは、AIの出力を鵜呑みにした典型的な失敗事例です。

参考URL:

https://www.forbes.com/sites/mollybohannon/2023/06/08/lawyer-used-chatgpt-in-court-and-cited-fake-cases-a-judge-is-considering-sanctions/

3. 出力結果の「酷似・盗用」による著作権トラブル

あるWebメディアが、記事作成の効率化のために生成AIを利用。AIが出力した文章が、別の既存記事と酷似していることに気づかずそのまま掲載してしまい、盗用(著作権侵害)であるとの指摘を受けるケースです。

これは、AIが学習データを単に「参考」にするだけでなく「暗記」し、ほぼそのまま出力してしまうリスクがあるためです。

【実例】

2023年には米ニューヨーク・タイムズが「AIが自社記事のテキストを『そのまま』逐語的に再現する」として、OpenAIとMicrosoftを著作権侵害で提訴する事態にも発展しています。

参考URL:

https://www.itmedia.co.jp/news/articles/2312/28/news100.html

4. マルウェア感染によるアカウント情報の窃取・流出

従業員が会社の管理下にないPC(私物PCなど)や、セキュリティ対策が不十分な端末でAIサービスを「シャドーIT」利用するケースは重大なリスクを伴います。こうした端末が情報窃取型マルウェア(InfoStealer)に感染すると、ブラウザに保存されていたAIサービスのログイン情報が盗み出されてしまいます。

【実例】

セキュリティ企業カスペルスキーの調査によると、2023年だけで約66万4千件ものOpenAI(ChatGPT含む)の認証情報が、こうしたマルウェアによって流出し、ダークウェブ(闇市場)上で確認されたと報告されています。盗まれたアカウントは不正アクセスの対象となってしまいます。

参考URL:

https://internet.watch.impress.co.jp/docs/news/1575799.html

生成AIの失敗事例についてもっと詳しく知りたい方はこちらの記事をご覧ください。

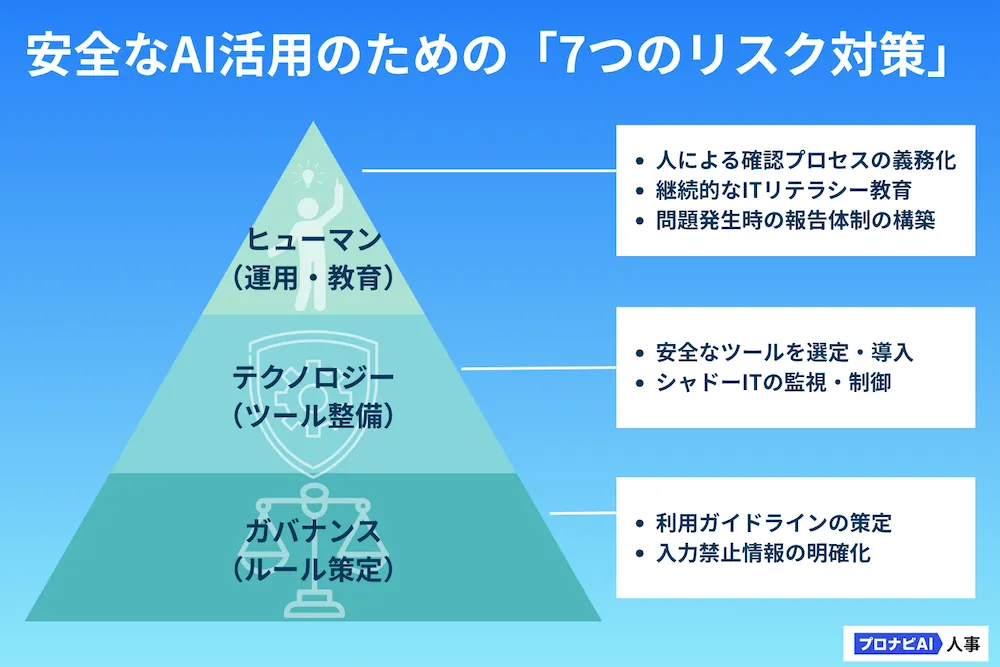

企業が今すぐ講じるべき7つの生成AIリスク対策

リスクを把握した上で、企業が講じるべき具体的な対策を解説します。

1. 全社共通の「利用ガイドライン」を策定する

対策の土台となるのが、全社共通の「利用ガイドライン(ルール)」の策定です。何を守り、許可し、禁止するのかを具体的かつ明確に明文化します。自社の実態に合わせ、最初のルールを定めることから始めます。

【ポイント】

- 利用目的の明確化

- AI利用の基本原則(AIは補助であり最終責任は人間にあること)

- 利用を許可するAIツール(後述)の指定

といった、全体方針を定めます。

ガイドライン策定の重要性についてもっと詳しく知りたい方はこちらの記事をご覧ください。

2. 入力禁止情報を明確に定義する

生成AIを安全に業務利用するため、ガイドラインで最も重要な項目は「何を入力してはいけないか」を明確にすることです。

【定義の例】

- 機密情報:社外秘の開発情報、財務データ、経営戦略資料、顧客との契約内容

- 個人情報:顧客や従業員の氏名、住所、電話番号、メールアドレス、評価データ

- 知的財産:特許出願前の情報、独自のソースコード

これらを明確に「入力禁止」と定めることで、生成AI利用に伴う最大のリスクである情報漏洩を防ぐことができます。

3. 安全な「企業向けAIツール」を選定・導入する

従業員の利便性を確保しつつシャドーITを防ぐには、会社として安全なAI利用環境を提供することが最も効果的です。

無料AIと企業向けAI(有料版)の決定的な違いは、「入力データをAIの学習に利用しない(オプトアウト)」設定が標準、あるいは契約で保証されている点です。

【代表的な企業向けサービス】

- Microsoft Azure OpenAI Service

- ChatGPT Enterprise / Team

- Google Cloud Vertex AI

これらのサービスは、入力データが自社の閉じた環境内で処理されるため、情報漏洩リスクを最小限に抑えられます。

4. 「シャドーIT」を技術的に監視・制御する

安全なツールを提供すると同時に、許可されていないAIサービスへのアクセスを技術的に制御・監視することも重要です。

【代表的な制御・監視ツール】

- CASB (Cloud Access Security Broker):従業員がどのクラウドサービス(AI含む)を利用しているかを可視化・制御します。

- DLP (Data Loss Prevention):機密情報や個人情報が社外(AIサービス含む)に送信されそうになった際に検知・ブロックします。

- URLフィルタリング:会社が許可していないAIサービスのドメインへのアクセスを一律で遮断します。

5. 出力結果の確認プロセスを義務化する

生成AIを安全に活用するには、AIの出力を鵜呑みにせず人間による確認プロセスを義務化することが重要です。これは、ハルシネーション(誤情報)や著作権侵害といったリスクに備えるためです。

【確認義務の例】

- ファクトチェック:生成された情報(数値、事実、判例など)が正確か、必ず別の情報源で裏付けを取る

- 著作権確認:生成された文章や画像が、既存の著作物と酷似していないか確認する(コピペチェックツールの利用も有効)

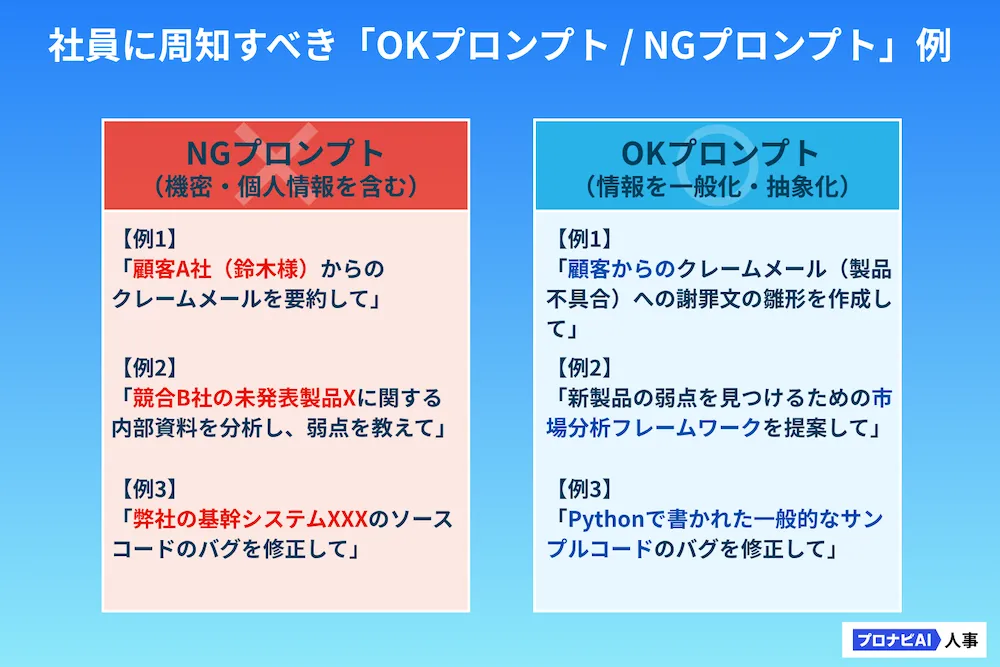

6. 継続的な「AIリテラシー教育」を実施する(OK/NG例の周知)

ガイドラインは「作って終わり」では形骸化します。なぜそのルールが必要なのか、リスクを理解してもらうための継続的なリテラシー教育が不可欠です。

特に、「どこまでが機密情報か」の判断は従業員によってバラつきがあるため、具体的なNG例を示すことが有効です。

生成AIリスク対策における役割分担

生成AIのリスク対策は、情シス部門だけでは完結しません。全社的な取り組みとして、各部門が連携する必要があります。

経営層・経営企画の役割

経営層は、AI活用を「攻め」と「守り」の両面からリードし、全社的な方針を決定する重要な役割を担います。

【主な役割】

- AI活用の全社的な方針(どの領域で活用し、どこは禁止するか)の決定

- リスク許容度(どこまでのリスクを受け入れるか)の設定

- 安全なAI環境を整備するためのIT投資判断

情報システム・セキュリティ部門の役割

情シス・セキュリティ部門は、AIリスク対策の実務を担う「事務局」であり、技術的な防波堤としての役割が求められます。

【主な役割】

- ガイドライン策定の事務局、および技術的な観点からのレビュー

- 安全なAIツール(企業向けサービス)の選定・導入・運用管理

- シャドーITの監視と技術的なアクセス制御の実施

- 従業員へのリテラシー教育の主導

法務・コンプライアンス部門の役割

法務・コンプライアンス部門は、AI利用が法的な問題や社会的な信用失墜に繋がらないよう、「法的・倫理的なブレーキ」としての役割を果たします。

【主な役割】

- 法的リスク(著作権、個人情報保護法、契約)の観点からのガイドラインレビュー

- AI利用に関する契約書(ツールベンダー、委託先)のリーガルチェック

- インシデント発生時の法的対応

現場部門・一般利用者の役割

最終的にAIを利用するのは現場の従業員です。どれだけ優れたルールやツールを導入しても、利用者が守らなければ意味がありません。日々の業務で「当事者意識」を持って実践することが求められます。

【主な役割】

- 策定されたガイドラインの遵守

- AIの出力結果を鵜呑みにせず、必ずファクトチェックと人間の目による修正を行う

- リスク(情報漏洩や著作権侵害の疑い)を発見した場合の、速やかな報告

リスク対策だけでは不十分? 安全に「活用」するための視点

ここまでリスク対策(守り)を中心に解説してきましたが、リスクを恐れて「生成AIの利用を一切禁止する」という判断は、かえって企業の競争力を削ぐ結果に繋がります。

重要なのは、「禁止」ではなく「リスクを管理下で利用推進する」という「攻め」の姿勢です。

「禁止」から「管理下での利用推進」へ

シャドーITが横行する最大の理由は「禁止されているが、使うと圧倒的に便利だから」です。禁止するほど、従業員は隠れて利用し、リスクはかえって増大します。 情シス部門が主導し、安全な企業向けAI環境を早期に提供することで、利用をポジティブに推進する土壌を作りましょう。